OPEN MATCH公式サイトで紹介されている入門ガイドでお試しで動かすopen-match-demoでエラーになったときのメモです。

open-match-demoを手順書通りにインストールしたはずが、こんな感じでエラーになってしまいました。

初めてminikubeを使ったので、エラーの原因を探すためのログを見る方法も分からなくて手間取りました。

結論から言うと、今回のエラーはVMのminikubeを一度削除して、再度minikubeを作り直したら正常に動かすことができました。

ちなみに環境は、Mac で Open Match のバージョンは0.9.0です。

open-match-demo の成功例

まず、open-match-demoが正常に設定できている場合の成功例です。

にアクセスすると画面はこんな感じで画面が動きます。

テキスト形式でコピーして抜き出してみるとこんな感じ。

{

"clients": {

"fakeplayer_0": {

"Status": "Sleeping (pretend this is playing a match...)",

"Assignment": {

"connection": "95.160.119.122:2222"

}

},

"fakeplayer_1": {

"Status": "Sleeping (pretend this is playing a match...)",

"Assignment": {

"connection": "186.94.109.137:2222"

}

},

"fakeplayer_2": {

"Status": "Sleeping (pretend this is playing a match...)",

"Assignment": {

"connection": "186.94.109.137:2222"

}

},

"fakeplayer_3": {

"Status": "Main Menu",

"Assignment": null

},

"fakeplayer_4": {

"Status": "Sleeping (pretend this is playing a match...)",

"Assignment": {

"connection": "95.160.119.122:2222"

}

}

},

"director": {

"Status": "Sleeping",

"LatestMatches": [

{

"match_id": "profile-a-simple-1v1-matchfunction-time-2020-03-02T07:48:56.36-num-0",

"match_profile": "a-simple-1v1-matchfunction",

"match_function": "a-simple-1v1-matchfunction",

"tickets": [

{

"id": "bpebknbshhevt5ak4qog"

},

{

"id": "bpebkq3shhevt5ak4qp0"

}

]

}

]

},

"uptime": 1161

}

今回の失敗例

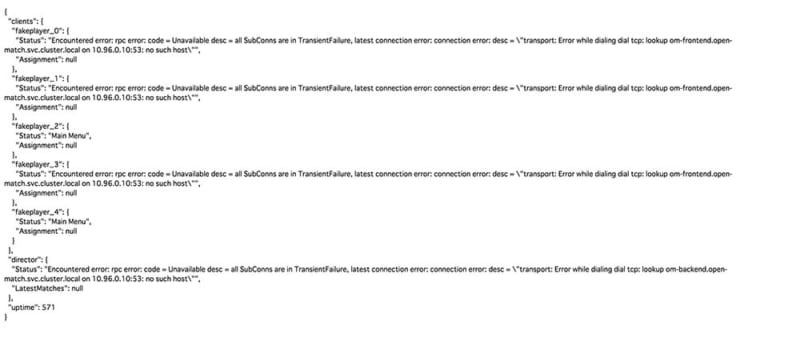

今回、自分がちょっとハマってしまい、発生した状態で画面を表示したらこんな感じになりました。

文言でみれば分かるようにエラーが出ていました。

{

"clients": {

"fakeplayer_0": {

"Status": "Encountered error: rpc error: code = Unavailable desc = all SubConns are in TransientFailure, latest connection error: connection error: desc = \"transport: Error while dialing dial tcp: lookup om-frontend.open-match.svc.cluster.local on 10.96.0.10:53: no such host\"",

"Assignment": null

},

"fakeplayer_1": {

"Status": "Main Menu",

"Assignment": null

},

"fakeplayer_2": {

"Status": "Encountered error: rpc error: code = Unavailable desc = all SubConns are in TransientFailure, latest connection error: connection error: desc = \"transport: Error while dialing dial tcp: lookup om-frontend.open-match.svc.cluster.local on 10.96.0.10:53: no such host\"",

"Assignment": null

},

"fakeplayer_3": {

"Status": "Encountered error: rpc error: code = Unavailable desc = all SubConns are in TransientFailure, latest connection error: connection error: desc = \"transport: Error while dialing dial tcp: lookup om-frontend.open-match.svc.cluster.local on 10.96.0.10:53: no such host\"",

"Assignment": null

},

"fakeplayer_4": {

"Status": "Main Menu",

"Assignment": null

}

},

"director": {

"Status": "Encountered error: rpc error: code = Unavailable desc = all SubConns are in TransientFailure, latest connection error: connection error: desc = \"transport: Error while dialing dial tcp: lookup om-backend.open-match.svc.cluster.local on 10.96.0.10:53: no such host\"",

"LatestMatches": null

},

"uptime": 388

}

なんかコネクションエラーが出ていました。

Encountered error: rpc error: code = Unavailable desc = all SubConns are in TransientFailure, latest connection error: connection error: desc = \"transport: Error while dialing dial tcp: lookup om-frontend.open-match.svc.cluster.local on 10.96.0.10:53: no such host\"

初めてminikubeを使うために、公式サイトのドキュメントを見つつ、minikubeをインストールから始めた人がハマる確率が高そうだなと思いました。

結論から言うと、VMのminikubeを一度削除して、再度minikubeを作り直したら正常に動かすことができました。

インストールからの流れを追ってみる

事前に「Minikubeを使用してローカル環境でKubernetesを動かす」を済ませておきます。

「YAMLでCore Open Matchをインストールする」手順書通りにインストールしていきます。

Core Open Matchサービスをインストールするコマンドを実行します。

kubectl apply --namespace open-match \ -f https://open-match.dev/install/v0.9.0/yaml/01-open-match-core.yaml

コマンドでOpne Matchコアをapplyした後のpodの状態はこんな感じになっていました。

$ kubectl get -n open-match pod NAME READY STATUS RESTARTS AGE om-backend-7bf7d94b55-jqbfc 0/1 ContainerCreating 0 9m18s om-backend-7bf7d94b55-z29sn 0/1 ContainerCreating 0 9m18s om-backend-7bf7d94b55-zvhld 0/1 ContainerCreating 0 9m18s om-frontend-5cdf4b6755-ks72l 0/1 ContainerCreating 0 9m18s om-frontend-5cdf4b6755-wc448 0/1 ContainerCreating 0 9m18s om-frontend-5cdf4b6755-wzp9x 0/1 ContainerCreating 0 9m18s om-query-5b8c9b88ff-bfvf2 0/1 ContainerCreating 0 9m18s om-query-5b8c9b88ff-czqv8 0/1 ContainerCreating 0 9m18s om-query-5b8c9b88ff-jfbnl 0/1 ContainerCreating 0 9m18s om-redis-master-0 0/2 Pending 0 9m18s om-redis-slave-0 1/2 Running 6 9m18s om-swaggerui-7bdc986547-r5mfc 0/1 Pending 0 9m18s om-synchronizer-7d4fc8cc95-28669 0/1 Pending 0 9m18s

このときはまだ問題無さそう。

つぎにデフォルトのEvaluatorをインストールするコマンドを実行します。

kubectl apply --namespace open-match \ -f https://open-match.dev/install/v0.9.0/yaml/06-open-match-override-configmap.yaml \ -f https://open-match.dev/install/v0.9.0/yaml/07-open-match-default-evaluator.yaml

ポッドの状態を簡易的に見る

コマンドを打った後にポッドの状態を「kubectl get -n open-match pod」で見てみます。

$ kubectl get -n open-match pod NAME READY STATUS RESTARTS AGE om-backend-7bf7d94b55-jqbfc 0/1 Running 0 13m om-backend-7bf7d94b55-z29sn 0/1 Running 0 13m om-backend-7bf7d94b55-zvhld 0/1 Running 0 13m om-evaluator-557b8c49b5-5vjdz 0/1 Pending 0 2m1s om-evaluator-557b8c49b5-kkgjh 0/1 Pending 0 2m1s om-evaluator-557b8c49b5-v6ctz 0/1 Pending 0 2m1s om-frontend-5cdf4b6755-ks72l 0/1 Running 0 13m om-frontend-5cdf4b6755-wc448 0/1 Running 0 13m om-frontend-5cdf4b6755-wzp9x 0/1 Running 0 13m om-query-5b8c9b88ff-bfvf2 0/1 Running 0 13m om-query-5b8c9b88ff-czqv8 0/1 Running 0 13m om-query-5b8c9b88ff-jfbnl 0/1 Running 0 13m om-redis-master-0 0/2 Pending 0 13m om-redis-slave-0 1/2 CrashLoopBackOff 7 13m om-swaggerui-7bdc986547-r5mfc 0/1 Pending 0 13m om-synchronizer-7d4fc8cc95-28669 0/1 Pending 0 13m

om-redis-slave-0がCrashLoopBackOffでコケてる状態になっているのが分かります。

「CrashLoopBackOff」はエラーなどで再起動を繰り返しているという意味。今回は7回再起動したみたい。

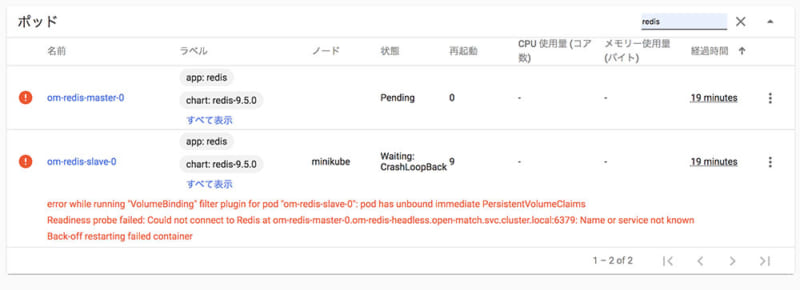

kubernetesのダッシュボード画面で状態を確認する

「minikube dashboard」コマンドでkubernetesのダッシュボード画面を開きます。

minikube dashboard

表示させ方は色々ありますが、左メニューのネームスペースから「open-match」を選択しポッドをクリックします。

正常に動作していれば名前の横のアイコンが緑色になっています。

今回エラーがある状態では、このようにアイコンが赤色になっていました。

「om-redis-slave-0」は、このようなエラーが出ていました。

error while running "VolumeBinding" filter plugin for pod "om-redis-slave-0": pod has unbound immediate PersistentVolumeClaims Readiness probe failed: Could not connect to Redis at om-redis-master-0.om-redis-headless.open-match.svc.cluster.local:6379: Name or service not known Back-off restarting failed container

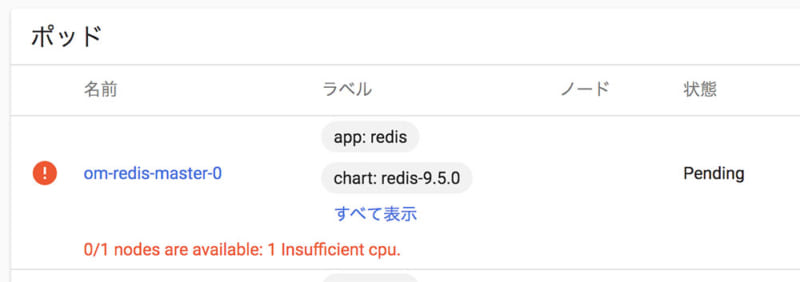

「om-redis-master-0」は、このようなエラーが出ていました。

「Insufficient cpu.」とあるので、「CPUが足りない」とエラーメッセージでした。

0/1 nodes are available: 1 Insufficient cpu.

このエラーログで、CPUが足りないことが原因ぽいという可能性が出てきました。

今回のエラーの原因

初めて「minikube start」でminikubeのクラスターVMを作成したけど、それ原因?

デモをインストールする前に「minikube start –cpus=3 –memory=2500mb」で起動したけど反映されていない?

そういえば、VMって毎回作り直さないよな。。。

CPUやメモリの割当って、最初に作ったときのままなのか?

「minikube start -h | grep -i cpu」でヘルプを見てみると、デフォルトだとCPUのコア数は2つらしい。。。

$ minikube start -h|grep -i cpu --cpus=2: Number of CPUs allocated to the minikube VM.

あー、これっぽいなぁ〜。

ということで、「minikube delete」でVMのminikubeを削除しました。

インストールのやり直し

一度「minikube delete」でVMのminikubeを削除しました。

その後、ドキュメント通り「minikube start –cpus=3 –memory=2500mb –vm-driver=virtualbox」で最初からやり直しです。

$ minikube start --cpus=3 --memory=2500mb --vm-driver=virtualbox 😄 minikube v1.7.3 on Darwin 10.13.6 ✨ Using the virtualbox driver based on user configuration 🔥 Creating virtualbox VM (CPUs=3, Memory=2500MB, Disk=20000MB) ... 🐳 Preparing Kubernetes v1.17.3 on Docker 19.03.6 ... 🚀 Launching Kubernetes ... 🌟 Enabling addons: default-storageclass, storage-provisioner ⌛ Waiting for cluster to come online ... 🏄 Done! kubectl is now configured to use "minikube"

「Creating virtualbox VM (CPUs=3, Memory=2500MB, Disk=20000MB) …」とCPUのコア数が3つで作られていますね。

最初にVM作ったときのログをさかのぼって見直したら、CPUsは2でした。

$ minikube start --vm-driver=virtualbox

🙄 minikube v1.7.3 on Darwin 10.13.6

✨ Using the virtualbox driver based on user configuration

⚠️ 'virtualbox' driver reported an issue: /usr/local/bin/VBoxManage list hostinfo failed:

💡 Suggestion: Install the latest version of VirtualBox

📘 Documentation: https://minikube.sigs.k8s.io/docs/reference/drivers/virtualbox/

💿 Downloading VM boot image ...

> minikube-v1.7.3.iso.sha256: 65 B / 65 B [--------------] 100.00% ? p/s 0s

> minikube-v1.7.3.iso: 167.39 MiB / 167.39 MiB [-] 100.00% 8.95 MiB p/s 19s

🔥 Creating virtualbox VM (CPUs=2, Memory=2000MB, Disk=20000MB) ...

💣 Unable to start VM. Please investigate and run 'minikube delete' if possible: creating host: create host timed out in 120.000000 seconds

あとはドキュメント通りに進めます。

Core Open Matchをインストールします。

Install the core Open Match services. kubectl apply --namespace open-match \ -f https://open-match.dev/install/v0.9.0/yaml/01-open-match-core.yaml

kubectl apply --namespace open-match \ -f https://open-match.dev/install/v0.9.0/yaml/06-open-match-override-configmap.yaml \ -f https://open-match.dev/install/v0.9.0/yaml/07-open-match-default-evaluator.yaml

「kubectl get -n open-match pod」で見ても、すべてSTATUSは「Runnning」で正常そう。

$ kubectl get -n open-match pod NAME READY STATUS RESTARTS AGE om-backend-7bf7d94b55-2kn8g 1/1 Running 0 79s om-backend-7bf7d94b55-cmcjp 1/1 Running 0 79s om-backend-7bf7d94b55-t7ndr 1/1 Running 0 79s om-evaluator-557b8c49b5-dtpfx 1/1 Running 0 47s om-evaluator-557b8c49b5-rssks 1/1 Running 0 47s om-evaluator-557b8c49b5-tfxmr 1/1 Running 0 47s om-frontend-5cdf4b6755-5s446 1/1 Running 0 79s om-frontend-5cdf4b6755-ggnzk 1/1 Running 0 79s om-frontend-5cdf4b6755-sjvwn 1/1 Running 0 79s om-query-5b8c9b88ff-qgn9w 0/1 Running 0 79s om-query-5b8c9b88ff-qnt5p 0/1 Running 0 79s om-query-5b8c9b88ff-z5t95 0/1 Running 0 79s om-redis-master-0 2/2 Running 0 78s om-redis-slave-0 2/2 Running 0 78s om-redis-slave-1 2/2 Running 0 20s om-swaggerui-7bdc986547-86s4n 1/1 Running 0 78s om-synchronizer-7d4fc8cc95-7clrb 0/1 Running 0 78s

今度こそ、うまくいった気がする!

公式サイトの手順通り、まずネームスペールを作ります。

kubectl create namespace open-match-demo

続いてデモをインストールします。

kubectl apply --namespace open-match-demo \ -f https://open-match.dev/install/v0.9.0/yaml/02-open-match-demo.yaml

デモのserviceを使用できる状態にします。

kubectl port-forward --namespace open-match-demo service/om-demo 51507:51507

ブラウザで「http://localhost:51507/」にアクセスして確認します。

無事に正常動作しました!

minikube startのログを出力する

今回は直接役立ちませんでしたが、minikube startコマンドに「 –alsologtostderr」を付けるとログが表示されます。

こんな感じで詳細なログが出力されるので、何か挙動が怪しい時に役立つかもしれません。

$ minikube start --vm-driver=virtualbox --alsologtostderr

I0225 17:13:17.319396 71718 notify.go:125] Checking for updates...

W0225 17:13:32.373885 71718 notify.go:56] Error getting json from minikube version url: error with http GET for endpoint https://storage.googleapis.com/minikube/releases.json: Get https://storage.googleapis.com/minikube/releases.json: net/http: TLS handshake timeout

I0225 17:16:12.261187 71718 start.go:249] hostinfo: {"hostname":"pc-name.local","uptime":2148732,"bootTime":1580469797,"procs":433,"os":"darwin","platform":"darwin","platformFamily":"","platformVersion":"10.13.6","kernelVersion":"17.7.0","virtualizationSystem":"","virtualizationRole":"","hostid":"d8347098-9b31-3c8e-a1c9-ca857f05bb97"}

W0225 17:16:12.261305 71718 start.go:257] gopshost.Virtualization returned error: not implemented yet

🙄 minikube v1.7.3 on Darwin 10.13.6

I0225 17:16:12.262252 71718 driver.go:211] Setting default libvirt URI to qemu:///system

✨ Using the virtualbox driver based on user configuration

I0225 17:16:33.047016 71718 start.go:296] selected driver: virtualbox

I0225 17:16:33.047044 71718 start.go:472] validating driver "virtualbox" against &{Name:minikube KeepContext:false EmbedCerts:false MinikubeISO:https://storage.googleapis.com/minikube/iso/minikube-v1.7.3.iso Memory:2000 CPUs:2 DiskSize:20000 Driver:virtualbox HyperkitVpnKitSock: HyperkitVSockPorts:[] DockerEnv:[] InsecureRegistry:[] RegistryMirror:[] HostOnlyCIDR:192.168.99.1/24 HypervVirtualSwitch: HypervUseExternalSwitch:false HypervExternalAdapter: KVMNetwork:default KVMQemuURI:qemu:///system KVMGPU:false KVMHidden:false Downloader: DockerOpt:[] DisableDriverMounts:false NFSShare:[] NFSSharesRoot:/nfsshares UUID: NoVTXCheck:false DNSProxy:false HostDNSResolver:true HostOnlyNicType:virtio NatNicType:virtio KubernetesConfig:{KubernetesVersion:v1.17.3 ClusterName:minikube APIServerName:minikubeCA APIServerNames:[] APIServerIPs:[] DNSDomain:cluster.local ContainerRuntime:docker CRISocket: NetworkPlugin: FeatureGates: ServiceCIDR:10.96.0.0/12 ImageRepository: ExtraOptions:[] ShouldLoadCachedImages:true EnableDefaultCNI:false} Nodes:[{Name:minikube IP: Port:8443 KubernetesVersion:v1.17.3 ControlPlane:true Worker:true}] Addons:map[]}

I0225 17:16:33.047233 71718 start.go:478] status for virtualbox: {Installed:true Healthy:false Error:/usr/local/bin/VBoxManage list hostinfo failed:

Fix:Install the latest version of VirtualBox Doc:https://minikube.sigs.k8s.io/docs/reference/drivers/virtualbox/}

⚠️ 'virtualbox' driver reported an issue: /usr/local/bin/VBoxManage list hostinfo failed:

💡 Suggestion: Install the latest version of VirtualBox

📘 Documentation: https://minikube.sigs.k8s.io/docs/reference/drivers/virtualbox/

W0225 17:16:33.047533 71718 start.go:511] selectDriver api.Load: filestore "minikube": Docker machine "minikube" does not exist. Use "docker-machine ls" to list machines. Use "docker-machine create" to add a new one.

I0225 17:16:33.047811 71718 downloader.go:67] acquiring lock: {Name:mka579c4e1b9276e04eec1da5f2bebca70ee091c Clock:{} Delay:500ms Timeout:10m0s Cancel:}

I0225 17:16:33.047973 71718 downloader.go:75] Not caching ISO, using https://storage.googleapis.com/minikube/iso/minikube-v1.7.3.iso

I0225 17:16:33.048287 71718 profile.go:100] Saving config to /Users/user_name/.minikube/profiles/minikube/config.json ...

I0225 17:16:33.050045 71718 start.go:244] acquiring machines lock for minikube: {Name:mk38e3b9693dd842eb30c21e84fa5fa7c93e3262 Clock:{} Delay:500ms Timeout:15m0s Cancel:}

I0225 17:16:33.050171 71718 start.go:248] acquired machines lock for "minikube" in 98.013µs

I0225 17:16:33.050200 71718 start.go:81] Provisioning new machine with config: {Name:minikube KeepContext:false EmbedCerts:false MinikubeISO:https://storage.googleapis.com/minikube/iso/minikube-v1.7.3.iso Memory:2000 CPUs:2 DiskSize:20000 Driver:virtualbox HyperkitVpnKitSock: HyperkitVSockPorts:[] DockerEnv:[] InsecureRegistry:[] RegistryMirror:[] HostOnlyCIDR:192.168.99.1/24 HypervVirtualSwitch: HypervUseExternalSwitch:false HypervExternalAdapter: KVMNetwork:default KVMQemuURI:qemu:///system KVMGPU:false KVMHidden:false Downloader:{} DockerOpt:[] DisableDriverMounts:false NFSShare:[] NFSSharesRoot:/nfsshares UUID: NoVTXCheck:false DNSProxy:false HostDNSResolver:true HostOnlyNicType:virtio NatNicType:virtio KubernetesConfig:{KubernetesVersion:v1.17.3 ClusterName:minikube APIServerName:minikubeCA APIServerNames:[] APIServerIPs:[] DNSDomain:cluster.local ContainerRuntime:docker CRISocket: NetworkPlugin: FeatureGates: ServiceCIDR:10.96.0.0/12 ImageRepository: ExtraOptions:[] ShouldLoadCachedImages:true EnableDefaultCNI:false} Nodes:[{Name:minikube IP: Port:8443 KubernetesVersion:v1.17.3 ControlPlane:true Worker:true}] Addons:map[]}

I0225 17:16:33.050946 71718 start.go:100] createHost starting for "minikube" (driver="virtualbox")

🔥 Creating virtualbox VM (CPUs=2, Memory=2000MB, Disk=20000MB) ...

I0225 17:16:33.051745 71718 start.go:136] libmachine.API.Create for "minikube" (driver="virtualbox")

I0225 17:16:33.051875 71718 main.go:110] libmachine: Reading certificate data from /Users/user_name/.minikube/certs/ca.pem

I0225 17:16:33.050575 71718 cache.go:91] acquiring lock: {Name:mkfe26613324ae874e4932e9c51f36675fc43c9b Clock:{} Delay:500ms Timeout:10m0s Cancel:}

I0225 17:16:33.052109 71718 cache.go:99] /Users/user_name/.minikube/cache/images/kubernetesui/metrics-scraper_v1.0.2 exists

I0225 17:16:33.052167 71718 cache.go:80] cache image "kubernetesui/metrics-scraper:v1.0.2" -> "/Users/user_name/.minikube/cache/images/kubernetesui/metrics-scraper_v1.0.2" took 1.581455ms

I0225 17:16:33.052187 71718 cache.go:65] save to tar file kubernetesui/metrics-scraper:v1.0.2 -> /Users/user_name/.minikube/cache/images/kubernetesui/metrics-scraper_v1.0.2 succeeded

I0225 17:16:33.050656 71718 cache.go:91] acquiring lock: {Name:mk9601d324e777b838022a24c20d9ff1fd3e86c0 Clock:{} Delay:500ms Timeout:10m0s Cancel:}

I0225 17:16:33.050687 71718 cache.go:91] acquiring lock: {Name:mk6949eb6450532a8216dfc682ed81236dfa4cfd Clock:{} Delay:500ms Timeout:10m0s Cancel:}

I0225 17:16:33.052297 71718 cache.go:99] /Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-proxy_v1.17.3 exists

I0225 17:16:33.052332 71718 cache.go:80] cache image "k8s.gcr.io/kube-proxy:v1.17.3" -> "/Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-proxy_v1.17.3" took 1.676376ms

I0225 17:16:33.052375 71718 cache.go:65] save to tar file k8s.gcr.io/kube-proxy:v1.17.3 -> /Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-proxy_v1.17.3 succeeded

I0225 17:16:33.050716 71718 cache.go:91] acquiring lock: {Name:mkd56ce249109b5bc883d92177ce7c961a13949a Clock:{} Delay:500ms Timeout:10m0s Cancel:}

I0225 17:16:33.052429 71718 main.go:110] libmachine: Decoding PEM data...

I0225 17:16:33.052451 71718 cache.go:99] /Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-controller-manager_v1.17.3 exists

I0225 17:16:33.052457 71718 main.go:110] libmachine: Parsing certificate...

I0225 17:16:33.052470 71718 cache.go:80] cache image "k8s.gcr.io/kube-controller-manager:v1.17.3" -> "/Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-controller-manager_v1.17.3" took 1.754964ms

I0225 17:16:33.052483 71718 cache.go:65] save to tar file k8s.gcr.io/kube-controller-manager:v1.17.3 -> /Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-controller-manager_v1.17.3 succeeded

I0225 17:16:33.050744 71718 cache.go:91] acquiring lock: {Name:mkb5b900e32fb54c8a447c32bdb30124e8897587 Clock:{} Delay:500ms Timeout:10m0s Cancel:}

I0225 17:16:33.052557 71718 cache.go:99] /Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-apiserver_v1.17.3 exists

I0225 17:16:33.052575 71718 cache.go:80] cache image "k8s.gcr.io/kube-apiserver:v1.17.3" -> "/Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-apiserver_v1.17.3" took 1.83165ms

I0225 17:16:33.052587 71718 cache.go:65] save to tar file k8s.gcr.io/kube-apiserver:v1.17.3 -> /Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-apiserver_v1.17.3 succeeded

I0225 17:16:33.050779 71718 cache.go:91] acquiring lock: {Name:mk6d3e6f389496e0ba724ef5bf6e6a605b4ea7be Clock:{} Delay:500ms Timeout:10m0s Cancel:}

I0225 17:16:33.052643 71718 main.go:110] libmachine: Reading certificate data from /Users/user_name/.minikube/certs/cert.pem

I0225 17:16:33.052685 71718 cache.go:99] /Users/user_name/.minikube/cache/images/k8s.gcr.io/coredns_1.6.5 exists

I0225 17:16:33.052702 71718 cache.go:80] cache image "k8s.gcr.io/coredns:1.6.5" -> "/Users/user_name/.minikube/cache/images/k8s.gcr.io/coredns_1.6.5" took 1.923763ms

I0225 17:16:33.052713 71718 cache.go:65] save to tar file k8s.gcr.io/coredns:1.6.5 -> /Users/user_name/.minikube/cache/images/k8s.gcr.io/coredns_1.6.5 succeeded

I0225 17:16:33.050807 71718 cache.go:91] acquiring lock: {Name:mk1786f4f7b6876fc25e17f7d1a398f48479751d Clock:{} Delay:500ms Timeout:10m0s Cancel:}

I0225 17:16:33.052721 71718 cache.go:99] /Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-scheduler_v1.17.3 exists

I0225 17:16:33.052750 71718 cache.go:80] cache image "k8s.gcr.io/kube-scheduler:v1.17.3" -> "/Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-scheduler_v1.17.3" took 2.063046ms

I0225 17:16:33.052765 71718 cache.go:65] save to tar file k8s.gcr.io/kube-scheduler:v1.17.3 -> /Users/user_name/.minikube/cache/images/k8s.gcr.io/kube-scheduler_v1.17.3 succeeded

I0225 17:16:33.050835 71718 cache.go:91] acquiring lock: {Name:mk3779f0251cf8cd0e0c8e5cd79bdc0ecee2ae03 Clock:{} Delay:500ms Timeout:10m0s Cancel:}

I0225 17:16:33.052776 71718 cache.go:99] /Users/user_name/.minikube/cache/images/k8s.gcr.io/etcd_3.4.3-0 exists

I0225 17:16:33.052795 71718 cache.go:80] cache image "k8s.gcr.io/etcd:3.4.3-0" -> "/Users/user_name/.minikube/cache/images/k8s.gcr.io/etcd_3.4.3-0" took 1.989431ms

I0225 17:16:33.052806 71718 cache.go:65] save to tar file k8s.gcr.io/etcd:3.4.3-0 -> /Users/user_name/.minikube/cache/images/k8s.gcr.io/etcd_3.4.3-0 succeeded

I0225 -17:16:33.050861 71718 cache.go:91] acquiring lock: {Name:mkd12355254768d337f34d7ec7681d4e2b40c42e Clock:{} Delay:500ms Timeout:10m0s Cancel:}

I0225 17:16:33.052849 71718 cache.go:99] /Users/user_name/.minikube/cache/images/k8s.gcr.io/pause_3.1 exists

I0225 17:16:33.052873 71718 cache.go:99] /Users/user_name/.minikube/cache/images/gcr.io/k8s-minikube/storage-provisioner_v1.8.1 exists

I0225 17:16:33.052892 71718 cache.go:80] cache image "gcr.io/k8s-minikube/storageprovisioner:v1.8.1" -> "/Users/user_name/.minikube/cache/images/gcr.io/k8s-minikube/storage-provisioner_v1.8.1" took 2.032351ms

I0225 17:16:33.052914 71718 cache.go:65] save to tar file gcr.io/k8s-minikube/storage-provisioner:v1.8.1 -> /Users/user_name/.minikube/cache/images/gcr.io/k8s-minikube/storage-provisioner_v1.8.1 succeeded

I0225 17:16:33.050901 71718 cache.go:91] acquiring lock: {Name:mk40a99ef33391c4cdc806ce36e84b6623f50562 Clock:{} Delay:500ms Timeout:10m0s Cancel:}

I0225 17:16:33.052947 71718 cache.go:80] cache image "k8s.gcr.io/pause:3.1" -> "/Users/user_name/.minikube/cache/images/k8s.gcr.io/pause_3.1" took 2.112287ms

I0225 17:16:33.052962 71718 cache.go:65] save to tar file k8s.gcr.io/pause:3.1 -> /Users/user_name/.minikube/cache/images/k8s.gcr.io/pause_3.1 succeeded

I0225 17:16:33.052979 71718 cache.go:99] /Users/user_name/.minikube/cache/images/kubernetesui/dashboard_v2.0.0-beta8 exists

I0225 17:16:33.052997 71718 cache.go:80] cache image "kubernetesui/dashboard:v2.0.0-beta8" -> "/Users/user_name/.minikube/cache/images/kubernetesui/dashboard_v2.0.0-beta8" took 2.096966ms

I0225 17:16:33.053008 71718 cache.go:65] save to tar file kubernetesui/dashboard:v2.0.0-beta8 -> /Users/user_name/.minikube/cache/images/kubernetesui/dashboard_v2.0.0-beta8 succeeded

I0225 17:16:33.053020 71718 cache.go:72] Successfully saved all images to host disk.

I0225 17:16:33.053116 71718 main.go:110] libmachine: Decoding PEM data...

I0225 17:16:33.053139 71718 main.go:110] libmachine: Parsing certificate...

I0225 17:16:33.053223 71718 main.go:110] libmachine: COMMAND: /usr/local/bin/VBoxManage --version

I0225 17:17:36.884502 71718 main.go:110] libmachine: STDOUT:

{

6.0.16r135674

}

I0225 17:17:36.884555 71718 main.go:110] libmachine: STDERR:

{

}

I0225 17:17:36.884627 71718 main.go:110] libmachine: COMMAND: /usr/local/bin/VBoxManage list hostonlyifs

I0225 17:18:33.052949 71718 start.go:103] createHost completed in 2m0.001720664s

I0225 17:18:33.052998 71718 start.go:72] releasing machines lock for "minikube", held for 2m0.002550302s

W0225 17:18:33.053163 71718 exit.go:101] Unable to start VM. Please investigate and run 'minikube delete' if possible: creating host: create host timed out in 120.000000 seconds

💣 Unable to start VM. Please investigate and run 'minikube delete' if possible: creating host: create host timed out in 120.000000 seconds

😿 minikube is exiting due to an error. If the above message is not useful, open an issue:

👉 https://github.com/kubernetes/minikube/issues/new/choose

コメント